A virtualização é uma área de crescimento exponencial na computação e nas TI, criando "virtualmente" um número ilimitado de possibilidades para os administradores de sistemas. A virtualização já existe há muitos anos, de uma forma ou outra, o problema é ser capaz de compreender os diferentes tipos de virtualização, o que eles oferecem, e como podem ajudar-nos.

A virtualização tem sido definida como a abstracção dos recursos do computador ou como uma técnica para esconder as características físicas dos recursos computacionais da forma como outros

sistemas, aplicações ou utilizadores interagem com esses recursos. De facto, virtualização sempre significa abstracção. Tornamos algo transparente adicionando camadas que lidam com traduções, fazendo com que os aspectos anteriormente importantes de um sistema se tornem quase irrelevantes.

Virtualização do Armazenamento

A quantidade de dados que as organizações estão a criar e armazenar, aumenta cada vez mais rapidamente devido à mudança de processos de negócios para aplicações digitais baseadas na Web e essa enorme quantidade de dados está a causar problemas para muitas delas. Em primeiro lugar, muitas aplicações geram mais dados que aqueles que podem ser armazenados fisicamente num único servidor. Depois, muitas aplicações, especialmente as baseadas na Internet, têm várias máquinas que precisam aceder aos mesmos dados. Ter todos os dados numa só máquina pode criar um estrangulamento, para não mencionar o risco que representa a situação em que muitas máquinas podem ser ficar inoperacionais se uma simples máquina, contendo todos os dados da aplicação, sofrer uma

falha. Finalmente, o aumento do número de máquinas de backup causa problemas porque tentar criar cópias de segurança de dados é uma tarefa enorme, quando há centenas ou até milhares de máquinas que precisam de backup de dados.

Por estas razões, os dados foram movidos para a virtualização. As empresas utilizam armazenamento centralizado (armazenamento virtualizado), como forma de evitar problemas de acesso a dados. Além disso, a mudança para o armazenamento de dados centralizado pode ajudar as organizações de TI a reduzir custos e melhorar a eficiência da gestão de dados. A premissa básica das soluções de virtualização de armazenamento não é nova. O armazenamento em disco há muito que conta com particionamento para organizar faixas do disco físico e sectores em clusters, e em seguida abstrair clusters em unidades de partição lógica (por exemplo, a unidade C:). Isso permite que o sistema operativo possa ler e gravar dados nos discos locais sem ter em conta a localização física dos bytes individuais nos pratos do disco.

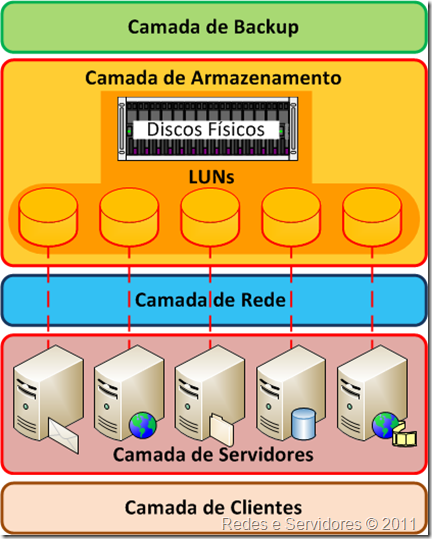

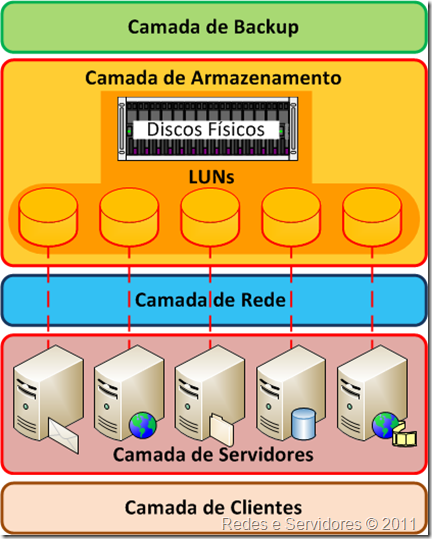

A virtualização de armazenamento cria uma camada de abstracção entre o sistema operativo e os discos físicos utilizados para armazenamento de dados. O armazenamento virtualizado é então independente do local, o que pode permitir a utilização mais eficiente e a melhor gestão do armazenamento. Por exemplo, o software de virtualização de armazenamento, ou dispositivo, cria um espaço lógico e gere de metadados que estabelecem um mapa entre o espaço lógico o espaço em disco físico. A criação do espaço lógico permite uma plataforma de virtualização para apresentar volumes de armazenamento que podem ser criados e alterados dando pouca atenção aos discos subjacente.

A camada de virtualização de armazenamento é onde os recursos de muitos dispositivos de armazenamento diferentes são agrupados de modo a que aparentem ser todos apenas um grande contentor de armazenamento. Este é então gerido por um sistema central que faz tudo parecer muito simples para os administradores de rede. Esta é também uma óptima maneira de monitorizar recursos porque é possível saber exactamente quanto está disponível num determinado momento e cria muito muito menos preocupações quando se trata de backups, etc.

Na maioria dos centros de dados, apenas uma pequena percentagem do armazenamento é usada porque, mesmo com uma

SAN, você tem que alocar uma LUN (

Logical Unit Number) inteira ao servidor (ou servidores) associado a essa LUN. Imaginemos que uma LUN enche, mas existe espaço em disco disponível noutra LUN. É muito difícil tirar o espaço em disco de uma LUN e dá-lo a outra LUN. Além disso, é muito difícil de misturar e combinar armazenamento e fazê-lo aparecer como um todo.

A virtualização de armazenamento funciona muito bem para espelhamento de tráfego através de uma WAN e para a migração de LUNs de um conjunto de armazenagem para outro, sem tempo de inactividade. Com alguns tipos de virtualização de armazenamento podemos, por exemplo, esquecer onde estão alocados os dados pois migrá-los para outro lugar é muito mais simples. De facto, muitos sistemas migram os dados com base na utilização de modo a optimizar o desempenho.