Inicialmente, as empresas desenvolveram aplicações em microcomputadores porque estes lhes davam mais liberdade que aquela que tinham no ambiente mainframe com as suas rígidas regras e processos. Em muitos aspectos, o microcomputador foi o primeiro passo para a libertação da computação em ambiente mainframe. No entanto, cada computador era agora gerido da maneira que o proprietário escolheu, sem normas padronizadas nem procedimentos normalizados o que levou ao surgimento de uma situação algo caótica. Além disso, como cada fornecedor de microcomputadores tinha seu próprio sistema operativo proprietário, os programas escritos para um ambiente eram muito dificilmente migrados para outro.

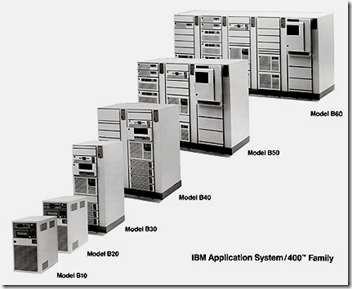

Paralelamente, quando a IBM lançou o primeiro computador pessoal em 1982, o modelo 5150, as empresas de todo o mundo iniciaram a instalação de computadores pessoais por toda a sua organização e sentiram grandes benefícios na utilização destas máquinas mais simples e baratas que faziam os mainframes parecer autênticas relíquias do passado. Esta proliferação de computadores pessoais acabou com a necessidade de virtualização como solução para a multitarefa. Mais tarde, em 1988, a IBM lança o Application System/400 (AS/400) que rapidamente se torna um dos sistemas de computação empresarial de maior sucesso em todo o mundo. Mas a já referida falta de compatibilidade entre sistemas e a impossibilidade de migrar aplicações entre eles, foram factores que ditaram a queda do modelo de computação pessoal baseado no microcomputador.

Além disso, há medida que o ambiente de computação se tornava cada vez mais complexo, as empresas despertaram para a necessidade de controlar os recursos de TI. O modelo de computação cliente-servidor chegou no início da década de 1990 e os microcomputadores, agora chamados servidores, começaram a ser alojados nas antigas salas onde estavam os velhos computadores de outrora. A disponibilidade de equipamentos de rede de qualidade e de baixo custo e de novos padrões de cablagem de rede tornou possível às empresas a adopção de uma arquitectura hierarquizada, colocando servidores numa sala dentro da empresa. É nesta altura que se difunde a utilização da expressão "datacenter" para designar as salas especialmente concebidas para alojar os servidores.

Artigo Anterior – Próximo Artigo